Processus Extract, Tranform, Load (ETL)

Processus Extract, Tranform, Load (ETL)

-

Objectifs

-

Présentation

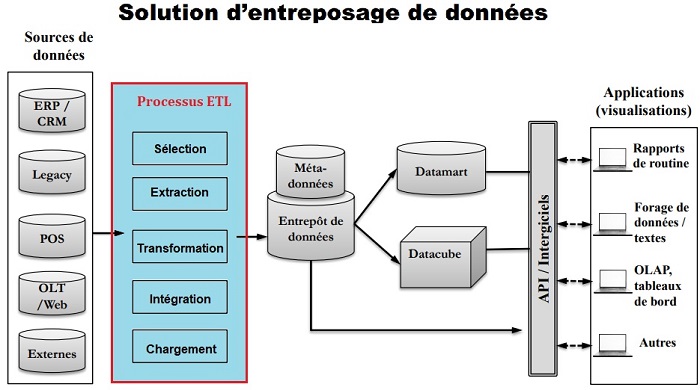

- Les termes « Extract, Transform, Load (ETL) » désignent une séquence d’opérations portant sur les données: collecte à partir d’un nombre illimité de sources, structuration, centralisation dans un référentiel unique.

- L’objectif d’ETL est de produire des données propres, faciles d’accès et qui peuvent être exploitées efficacement par l’analytique, la Business Intelligence ou/et les opérations commerciales.

- Extraire les données des sources hétérogènes (

extract) - Identifier les données sources utiles

- Déterminer les données qui ont changé

- Consolider les données (

transform) - Données redondantes, manquantes, incohérentes, etc.

- Découpage, fusion, conversion, aggrégation, etc.

- Charger les données intégrées dans l’entrepôt (

load) - Mode différé (batch) ou quasi temps-réel.

-

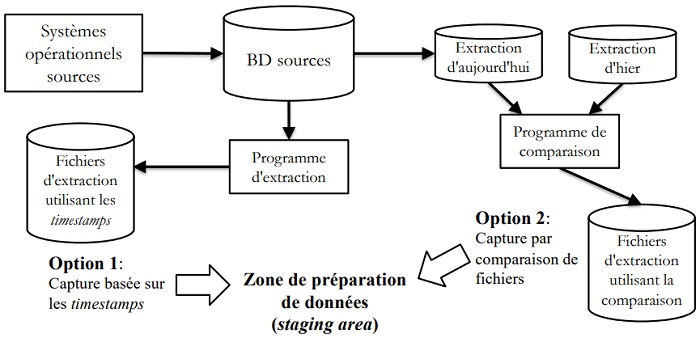

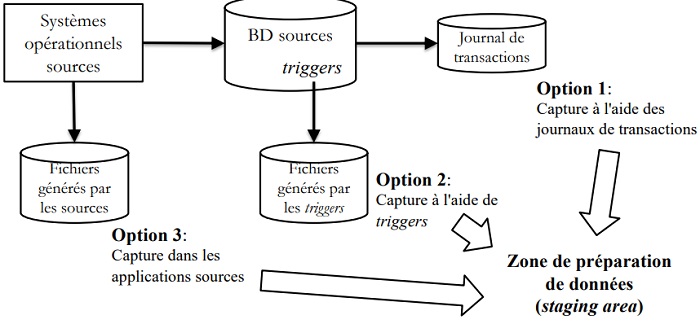

Extraction des données

- Les données brutes peuvent être extraites de différentes sources, en particulier :

- Bases de données existantes

- Logs d’activité (trafic réseau, rapports d’erreurs, etc.)

- Comportement, performances et anomalies des applications

- Événements de sécurité

- Autres opérations qui doivent être décrites aux fins de conformité

- Les données extraites sont parfois stockées dans un emplacement tel qu’un data lake ou un data warehouse.

-

Différée

- Extrait tous les changements survenus durant une période donnée (ex: heure, jour, semaine, mois).

-

Temps réel

- S’effectue au moment où les transactions surviennent dans les systèmes sources.

-

Transformation des données

- La transformation applique les règles définies en interne. Les normes qui garantissent la qualité des données et leur accessibilité doivent tenir compte des pratiques suivantes :

- Révision de format:_Changer le type ou la longueur de champs individuels

- Décodage de champs:[‘homme’, ‘femme’] vs [‘M’, ‘F’] vs [1,2]

- Pré-calcul des valeurs dérivées: Ex: profit calculé à partir de ventes et coûts.

- Découpage de champs complexes: Ex: extraire les valeurs prénom, secondPrénom et nomFamille à partir d’une seule chaîne de caractères nomComplet.

- Pré-calcul des agrégations: Ex: ventes par produit par semaine par région.

- Déduplication : Transmettre un rapport sur les doublons aux personnes en charge de la gouvernance des données ; exclure et/ou supprimer les données redondantes.

- Vérification : Effectuer des vérifications automatisées pour comparer des données similaires telles que durée de transaction ou suivi des accès. Les tâches de vérification permettent d’éliminer les données inutilisables et de signaler les anomalies des systèmes, des applications ou des données.

-

Chargement des données

- Faire les chargements en lot dans une période creuse (entrepôt de données non utilisé);

- Considérer la bande passante requise pour le chargement;

- Avoir un plan pour évaluer la qualité des données chargées dans l’entrepôt;

- Commencer par charger les données des tables de dimension;

- Désactiver les indexes et clés étrangères lors du chargement.